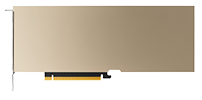

NVIDIA H100 - das neue Flaggschiff für Enterprise GPU Computing

06.07.2022Nach Volta und Ampere stellt NVIDIA auf der hauseigenen KI-Konferenz, der GTC 2022, ihre neue Enterprise GPU H100 auf Basis der Hopper Architektur vor. Laut NVIDIA handelt es sich bei der H100 um die "komplexeste GPU" der Firmengeschichte, deren Fokus stärker denn je auf KI und Machine-Learning liegt.

80 Milliarden Transistoren

Der GH100-Chip kommt mit einer Fläche von 814mm², 12mm² kleiner als der GA100, und das bei eineinhalbfacher Transitoranzahl. Gefertigt wird dieser wieder von TSMC, in einem eigens für NVIDIA optimierten Fertigungsverfahren mit dem Namen 4N, welches eine weiterentwickelte Form des N5-Prozesses darstellt.

4. Gen Tensor Cores: Wesentlich mehr Leistung für KI, Deep Learning und HPC Anwendungen

Die Hopper-Architektur arbeitet mit Tensor-Kernen der vierten Generation, und bietet Geschwindigkeiten, die die der A100 um das bis zu sechsfache übertreffen. So leistet die H100 bei FP64-Geschwindigkeiten 60 TeraFLOPS (SXM) bzw. 48 TeraFLOPS (PCIe), im FP16-Bereich schafft die SXM-Version 2.000 TeraFLOPS, die PCIe-Version 1.600 TeraFLOPS, ca. die dreifache Leistung der A100.

Bei den INT8-Geschwindigkeiten setzt sich die H100 noch weiter von ihrem Vorgänger ab. So kommt die SXM-Variante auf Geschwindigkeiten von bis zu 4.000 TOPS, PCIe auf 3.200 TOPS. Beide Ausführungen kommen mit einem internen GPU-Arbeitsspeicher von 80 GB. Die ausführlichen Spezifikationen der NVIDIA H100 PCIe finden Sie auf unserer Produktseite.

NVIDIA H100 vs A100 - technische Daten auf einen Blick

| Modell |  |  |  |

| FP64 | 30 TFLOPS | 24 TFLOPS | 9,7 TFLOPS |

| FP64-Tensor-Core | 60 TFLOPS | 48 TFLOPS | 19,5 TFLOPS |

| FP32 | 60 TFLOPS | 48 TFLOPS | 19,5 TFLOPS |

| Tensor Float 32 (TF32) | 1.000 TFLOPS* | 800 TFLOPS* | 156 TFLOPS* |

| BFLOAT16-Tensor-Core | 2.000 TFLOPS* | 1.600 TFLOPS* | 312 TFLOPS* |

| FP16-Tensor-Core | 2.000 TFLOPS* | 1.600 TFLOPS* | 312 TFLOPS* |

| INT8-Tensor-Core | 4.000 TOPS* | 3.200 TOPS* | 624 TOPS* |

| GPU-Speicher | 80 GB HBM3 | 80 GB HBM2e | 80 GB HBM2e |

| GPU-Speicherbandbreite | 3.072 GB/s | 2.048 GB/s | 1.935 GB/s |

| Max Thermal Design Power (TDP) | 700 W | 350 W | 300 W |

| Mehr-Instanzen-GPU (MIG) | Bis zu 7 MIG's mit 10 GB | Bis zu 7 MIG's mit 10 GB | Bis zu 7 MIG's mit 10 GB |

| Formfaktor | SXM | PCIe Gen5 | PCIe Gen4 |

| Verfügbarkeit | - | ||

| Konnektivität | NVLink: 900 GB/s / PCIe Gen5: 128 GB/s | NVLink: 600 GB/s / PCIe Gen5: 128 GB/s | NVLink: 600 GB/s / PCIe Gen4: 64 GB/s |

| Serveroptionen | NVIDIA HGX H100-Partner und NVIDIA-zertifizierte Systeme mit 4 oder 8 GPU's, NVIDIA DGX H100 mit 8 GPU's | Partner und NVIDIA-zertifizierte Systeme mit 1–8 GPU's | Partner und NVIDIA-zertifizierte Systeme mit 1-8 GPUs |

Multi-Instance GPU (MIG)

Dank der NVIDIA H100 mit MIG können Infrastrukturmanager ihre GPU-beschleunigte Infrastruktur standardisieren und gleichzeitig GPU-Ressourcen mit größerer Granularität bereitzustellen, um Entwicklern sicher die richtige Menge an beschleunigter Rechenleistung zur Verfügung zu stellen. So kann die Nutzung der GPU-Ressourcen optimiert werden.

Möglich wird dies durch das Aufteilen der GPU in kleinere, vollständig voneinander isolierte Instanzen mit eigenem Speicher, eigenem Cache sowie Recheneinheiten. Die Hopper Architektur Hopper erweitert die Funktionalität von MIG durch die Unterstützung von Multi-User-Konfigurationen in virtualisierten Umgebungen - ideal für Cloud-Service-Provider-Umgebungen (CSP).

NVIDIA Confidential Computing

Moderne vertrauliche Computing-Lösungen sind CPU-basiert, was für rechenintensive Workloads wie KI und HPC zu begrenzt ist. NVIDIA Confidential Computing ist eine integrierte Sicherheitsfunktion der NVIDIA Hopper-Architektur, die NVIDIA H100 zum weltweit ersten Beschleuniger mit vertraulichen Computing-Funktionen macht. Nutzer können die Vertraulichkeit und Integrität Ihrer Daten und Anwendungen schützen und gleichzeitig von der unübertroffenen Beschleunigung der H100-Grafikprozessoren für KI-Workloads profitieren. Es entsteht eine hardwarebasierte vertrauenswürdige Ausführungsumgebung (TEE), die den gesamten Workload schützt und isoliert. Dieser wird auf einer einzigen H100-GPU, mehreren H100-GPUs innerhalb eines Knotens oder einzelnen MIG-Instanzen ausgeführt. GPU-beschleunigte Anwendungen können im TEE unverändert ausgeführt werden und müssen nicht partitioniert werden. Nutzer können die Leistungsfähigkeit von NVIDIA-Software für KI und HPC mit der Sicherheit einer Hardware-Root-of-Trust-Anwendung kombinieren, die von NVIDIA Confidential Computing angeboten wird.

ERFAHREN SIE MEHR ÜBER CONFIDENTIAL COMPUTING VON NVIDIA